Entre junho e agosto de 1956, um grupo de cientistas agitou o campus do renomado Dartmouth College, em New Hampshire. Nomes lendários da computação como John McCarthy, Oliver Selfridge, Marvin Minsky e Trenchard More discutiram a automação, matéria que florescia na academia e dividia opiniões sobre a capacidade de máquinas de exercer tarefas humanas. McCarthy, então professor de matemática em Dartmouth, é apontado como autor do termo inteligência artificial (I.A.), que usou no convite para o evento. Batizou um campo de estudos que nunca mais deixaria de criar expectativa e polêmica. Aquele brainstorm de quase oito semanas ofereceu uma visão de futuro. Os especialistas acreditavam na construção de computadores para desempenhar tarefas ligadas à cognição, incluindo abstração e uso de linguagem. “Todos os aspectos da aprendizagem — ou qualquer outra característica da inteligência — podem, em princípio, ser descritos tão precisamente que uma máquina será capaz de simulá-los”, resumia o programa.

Nas últimas décadas, os avanços científicos combinados ao barateamento dos recursos computacionais, como servidores e software, pavimentaram a nova era da I.A., com a criação de sistemas capazes de falar, ouvir, ver, ler e escrever. Em centrais de atendimento, o uso de bots, programas escritos para interagir com as pessoas, não é mais novidade. Esse tipo de software entende questões, responde, encaminha solicitações e resolve problemas simples. “As técnicas de linguagem natural estão tão refinadas que é difícil perceber que o atendente é um robô”, diz Jacques Chicourel, diretor de negócios digitais da Atento, multinacional de contact center. E a capacidade crescente de comunicação das máquinas desperta a curiosidade e o medo de quem assiste à revolução da I.A. sem conhecer seus bastidores. Não há dúvida de que a tecnologia pode automatizar uma série de tarefas, mas é preciso entender seus limites — e seu alcance.

Neste momento, aqui e agora, a I.A. consegue analisar vastas quantidades de dados e detectar padrões, a fim de assumir tarefas ou mesmo revelar insights de onde nós, humanos, só veríamos uma massa impenetrável de números. Considere os seguintes casos, ocorridos a partir de 2015 e validados pela escola de negócios Sloan, do prestigioso Massachusetts Institute of Technology (MIT):

— A seguradora alemã Allianz implementou uma I.A. que aumentou a detecção de tentativas de fraude em cerca de 50%, quase que imediatamente após entrar em funcionamento.

— A Chevron, produtora americana de petróleo, adotou o recurso em diversas áreas da companhia, incluindo revisão de contratos. Graças à tecnologia, detectou gastos não justificados que antes eram invisíveis.

— A fabricante de produtos químicos suíça Clariant criou seu projeto de I.A. para reduzir custos. O resultado veio tão rápido que o recurso foi levado para as frentes geradoras de receita — precificação dos produtos, detecção de novas oportunidades no portfólio de clientes, criação de linhas de produtos.

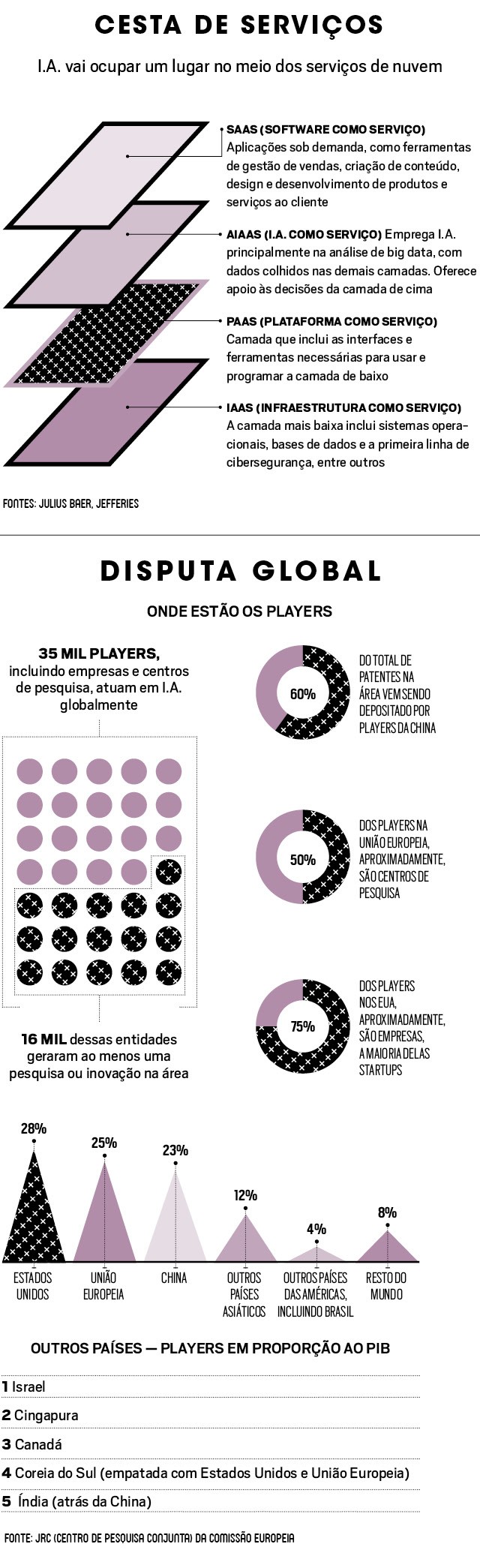

Compreende-se, então, por que esses sistemas consumiram US$ 24 bilhões em 2018 (segundo o IDC) e deverão estar presentes em 70% das empresas até 2030 (segundo a McKinsey). A princípio, frente a tantas facilidades, pode parecer óbvio para qualquer companhia que adotar sistemas de I.A. é a melhor decisão a ser tomada. É comum a crença de que basta colocar o sistema para funcionar e… pronto! Tudo estará resolvido. No mundo real dos negócios, no entanto, não é tão simples.

Um dos casos mais emblemáticos do desafio das organizações na implementação de sistemas de I.A. é o da parceria entre a IBM e o M.D. Anderson, centro de referência mundial em pesquisa e tratamento de câncer. Em 2013, o hospital investiu US$ 62 milhões no Watson, a plataforma de I.A. da IBM. A ideia era a de que a máquina ajudasse os médicos no diagnóstico e cuidado dos doentes. “Até agora nenhum paciente foi tratado e a iniciativa está suspensa”, disse Tom Davenport, professor de tecnologia da informação do Babson College e pesquisador no centro de negócios digitais do MIT, em um seminário online, realizado em dezembro de 2018.

O problema não é o Watson em si, mas a expectativa que se cria em torno da I.A. Entre a instalação e ela funcionar como o imaginado, há uma grande distância. O trabalho de treinamento e captura e curadoria de dados é enorme, de longa maturação e custos imprevisíveis. Como o M.D. Anderson tinha demandas mais urgentes (e que se pagariam mais rapidamente), o hospital abandonou o Watson. Em um artigo para o jornal inglês Financial Times, o empresário Zia Chishti provoca: “Documentos internos da IBM indicam que o Watson recomendou tratamentos perigosos e equivocados. Do Jeopardy! [programa da TV americana de perguntas e respostas vencido certa vez pela I.A. da gigante de tecnologia] ao diagnóstico do câncer, o caminho é um pouco mais complicado do que a IBM imaginou”. Zia é fundador e CEO da Afiniti, multinacional de dados e software.

O ocorrido com o hospital americano tem acontecido com várias empresas mundo afora. “A I.A. não é uma questão de tecnologia, mas, sim, de negócios”, diz Jacques Chicourel, da Atento. “Sem entender a demanda, não se começa projeto técnico.” Para o uso adequado da I.A., é imprescindível que, em primeiro lugar, se desenhe a solução para então escolher qual plataforma tecnológica adotar. Sem esse cuidado, projetos anunciados como revolucionários podem cair no mais profundo ostracismo.

O último levantamento da consultoria americana Gartner mostra que há muita discussão e pouca clareza sobre I.A. Apenas 4% das empresas usam de fato a tecnologia. Algumas soluções de análise de dados, por exemplo, podem ser resolvidas com modelagem estatística, mas, apenas por envolver o termo algoritmo, são vendidas como I.A. Há bots de tomadas de decisão construídos a partir de árvores de decisões pré-programadas — “se acontecer isso, faça aquilo”; “se o cliente escrever ou escolher tal, faça assim”. Sem dúvida, é um sistema esperto, mas não é I.A. “O assédio para ingressar na tecnologia é grande e muitos acham que I.A. é a grande chave para resolver qualquer coisa”, diz Abel Reis, CEO do Grupo Dentsu Aegis Network no Brasil. “E não é bem assim.” Para ele, vai levar tempo para acomodar os conceitos de I.A. dentro das empresas.

Do total de companhias avaliadas pela Gartner, 37% está em fase de formulação de estratégias e 35% admite dificuldades na identificação das oportunidades para uso. Para o futuro, no médio e longo prazo, a I.A. oferece possibilidades assombrosas. Para o curto prazo, porém, a recomendação dos especialistas é ajustar as expectativas — conhecendo mais profundamente a tecnologia. “O fato é que as últimas encarnações de I.A. não são muito melhores resolvendo problemas complexos do que suas antecessoras de 30 anos atrás”, lê-se no texto de Zia.

No final de fevereiro, em palestra no MWC Barcelona, um dos maiores eventos de tecnologia do mundo, o matemático Wanli Min, principal cientista do Alibaba, foi preciso ao listar os tipos de inteligência com as quais uma organização pode contar. Entre elas, lá estava o que ele chamou de “I.H.”, inteligência humana, criativa e empática. No mundo dos negócios, o grande desafio é combinar as duas. Na batalha entre as inteligências, frise-se, não há vencedora. A artificial e a humana trabalham bem se trabalham juntas. “Toda inteligência artificial é essencialmente burra”, diz Robert Duque Ribeiro, diretor da Accenture. “Ela só funciona a partir de regras escritas por humanos. No final das contas, a máquina vai refletir o que nós inserimos nela.” Para ele, o grande desafio que a I.A. nos impõe é determinar a melhor maneira de aplicá-la.

Robert, da Accenture, sugere ainda que se observem os problemas com mais frieza. Se o momento da empresa é de automação de processos repetitivos, ela não precisa de I.A. “Muitos dizem ter implementado I.A., mas não o fizeram”, diz o executivo. Abel, do Denstsu, usuário de chatbots, lista trabalhos que podem ser automatizados, como a emissão de relatórios, ordens de serviços e notas fiscais. “Mesmo que o robô seja capaz de ‘ler’ a nota fiscal buscando dados, não dá para considerar I.A., porque ele apenas rastreia padrões predeterminados e os processa dentro de uma fórmula definida”, diz. Fábio Andreotti, líder da área de computação em nuvem do Google, resume: “Se o algoritmo não é capaz de aprender com dados, não é inteligência artificial”.

Empresas nesse estágio não devem ver isso como um problema. A demanda por automação de processos, com uso de algoritmos e modelos estatísticos, é gigantesca. Isso ainda aparece como necessidade mesmo numa economia muito mais produtiva do que a brasileira. Ao conduzir um estudo para a Deloitte, o professor Davenport constatou que entre 20% e 30% das empresas já começaram a aplicar tecnologias cognitivas em alguns processos. Mas o que as empresas querem mesmo, 63% delas, é automatizar o máximo de tarefas possível.

Diferentes aplicações pedem I.A. com capacidades mais específicas. Pode ser que uma empresa requeira um sistema que entenda linguagem natural, para conversar com os clientes por meio de voz ou texto. Talvez a necessidade seja por visão computacional, para identificar imagens. Entre os usos de I.A. para o consumidor final, o brasileiro já se habituou às recomendações de serviços como Amazon e Netflix, à busca de fotos por imagem do Google e a assistentes pessoais como a Siri, da Apple.

Outro uso que se difunde é no atendimento por meio de chatbots e telefonistas virtuais. A Aura, I.A. da Vivo no Brasil, vai ser levada para outros países (o bot foi apresentado como caso no MWC, em Barcelona, e tema de conversa entre os CEOs da Telefônica, José María Álvarez-Pallete, e da Microsoft, Satya Nadela).

A Atento conta com modelos para supervisionar ligações. A ferramenta “ouve” as conversas entre clientes e atendentes humanos para identificar dissonâncias causadas por estresse. “Ao identificar a probabilidade de cancelamento do contrato ou da venda, o software insere informações para auxiliar o atendente ou transfere a ligação para um profissional capaz de reverter a situação”, diz Jacques, da Atento. Na comparação com os atendentes humanos, os robôs são 20% mais produtivos.

A I.A. pode ser dividida em quatro grupos: linguagem natural, visão computacional, robótica e aprendizado de máquina ou machine learning (leia o glossário mais abaixo). É esta última, aliás, que mais se aproxima dos negócios atualmente. Oito de cada dez projetos de I.A. em produção no mundo hoje são de aprendizado de máquina. “Ainda estamos na era de entender e filtrar dados para ensinar sistemas”, diz Alexandre Dietrich, executivo de Watson da IBM Brasil. “É prematuro falar de tecnologias mais complexas, principalmente no âmbito das corporações.”

A IBM trabalha com o conceito de inteligência aumentada. A ideia, segundo Alexandre, é fazer com que as máquinas sejam usadas para ampliar a inteligência humana, processando dados e buscando informações para nos ajudar a tomar decisões e a ser mais produtivos. Por enquanto, a função da I.A. não é pensar, mas realizar tarefas que nos tomam tempo. Esse é o futuro próximo que deve se materializar muito antes de sonharmos (ou termos pesadelos) com a inteligência artificial genérica, aquela dotada de senso comum, flexibilidade e capacidade de deliberar objetivos próprios, como se vê na ficção científica. Há preocupações mais imediatas.

Definido em 1943, o aprendizado de máquina se explica assim: ao processar e identificar padrões, o sistema aprende. E, quanto mais trabalha, mais ele aprende — sozinho, sem que um programador humano precise lhe fornecer novas regras. Isso só é possível graças à arquitetura de rede neural, que simula o funcionamento do cérebro humano. O aprendizado de máquina está organizado em camadas de neurônios artificiais. Aqui, um parêntese. Há três tipos de camadas. Na de entrada, os padrões são apresentados à rede. Nas intermediárias, chamadas também de escondidas, ocorre o processamento. Na de saída, tem-se a apresentação do resultado final. Quanto maior o número de camadas, mais profundo (e, consequentemente, mais sofisticado) é o aprendizado. O deep learning, em geral, nos fornece conselheiros de alta qualidade.

Leia mais

Startups vão mudar a forma que você compra, aluga ou reforma sua casa

Empresa brasileira cria robô que busca empréstimos com taxas mais baixas

4 empreendedores que criaram grandes empresas em momentos de crise

Gábor Takács, chefe de ciência de dados da Cujo AI, empresa que utiliza I.A. em cibersegurança, lembra a história de um sistema que, graças a 50 camadas de neurônios artificiais, foi capaz de detectar imagens de sexo explícito entre outras tantas imagens de casais em situação de intimidade.

Um dos trabalhos mais pujantes em rede neural foi desenvolvido por Fei-Fei Li, codiretora do Instituto de Inteligência Artificial Centrada em Humanos da Universidade Stanford. Ela é cofundadora do ImageNet, banco com milhões de fotografias, usadas em pesquisas e construção de software de reconhecimento visual. Fei-Fei penou para ensinar robôs a identificar o mundo por imagens. “É difícil descrever objetos em algoritmos matemáticos”, contou ela, em um TED Talk.

Suas pesquisas só deslancharam quando ela, ao observar crianças, percebeu que o cérebro humano aprende a enxergar por meio da exposição a imagens. “Os olhos são como um par de câmeras biológicas, que tiram uma foto a cada 200 milissegundos. Aos 3 anos, uma criança já terá visto centenas de milhões de imagens”, conta a cientista. “Para conseguir enxergar um gato, o algoritmo tem de ser exposto a milhares deles.” Atualmente, o ImageNet conta com 15 milhões de imagens.

Graças a uma intricada rede de neurônios, nós pensamos, sentimos, nos emocionamos… Interagimos com o mundo ao nosso redor. As células nervosas dispõem, em suas extremidades, de estruturas chamadas dendritos, responsáveis por receber e encaminhar informações vindas de outros neurônios. Em programação, as redes neurais imitam esse processo biológico.

Componentes matemáticos (programas ou algoritmos) se comunicam entre si para tratar e processar essas informações. É nesse sistema de interação entre as unidades de processamento da rede que reside a inteligência da I.A. Para o ImageNet, por exemplo, Fei-Fei computou 24 milhões de componentes matemáticos em seus sistemas, que foram abastecidos por 140 milhões de parâmetros e 15 bilhões de conexões. A título de comparação, no cérebro humano as comunicações entre os neurônios somam 100 trilhões. O próximo passo é unir a visão à fala, construindo robôs capazes de descrever o que veem.

Até contarmos com um sistema dotado de funções cognitivas, há uma longa jornada na captação, limpeza e curadoria dos dados. A construção da base que alimentará o cérebro da I.A. exige planejamento prévio da companhia. Apenas com a trilha da informação definida, as técnicas de I.A. tornam-se úteis para “mastigar” as informações e então torná-las compreensíveis e úteis para os humanos. “O usuário final não está interessado na tecnologia embarcada no aplicativo”, diz Pedro Rocha, gerente de produto da Climate, divisão de agricultura digital da Bayer.

No campo, por exemplo, os algoritmos combinam, calculam e avaliam mais de 40 variáveis, antes de indicar o dia ideal para deitar as sementes no solo. Da umidade da terra à previsão do tempo para os próximos dias. Com técnicas que vão de análise complexa de dados — com uso de big data — ao aprendizado de máquinas, a Climate capta informações em 24 milhões de hectares plantados e as cruza com bancos de dados agronômicos, de produção e de clima. Com isso, é possível tirar uma “fotografia” em tempo real da lavoura e entregar informações como a probabilidade do avanço de uma praga, sugerindo ação imediata ao agricultor.

O cuidado com o que vai alimentar a I.A. é fundamental para obter resultados úteis e reduzir riscos. “Do trabalho de um cientista de dados, a profissão do momento, 90% consiste em limpeza das bases de dados”, diz Luis Moneda, cientista de dados no Nubank. A instituição mantém 30 modelos estatísticos capazes de tomar decisões autônomas em funções que envolvem análise de crédito, entendimento do comportamento e atendimento ao cliente. São mais de 5 milhões de clientes e 20 milhões de pessoas solicitando cartão. A empresa opera em ambiente extremamente regulado, e não pode correr nenhum risco de descumprir normas nem incorrer em análises distorcidas dos clientes. Uma equipe de 25 profissionais, entre cientistas de dados e engenheiros, acompanha o aprendizado das I.As.

No aprendizado supervisionado, um especialista age como “professor” e ministra dados pré-classificados, para garantir que a I.A. detecte exatamente os padrões desejados, diz Flavio Abdenur, sócio da SLQ Soluções Qualitativas. Para Thiago Rotta, diretor de Inovação e Transformação Digital da Microsoft Brasil, é o sistema mais indicado. A própria Microsoft passou por um perrengue quando lançou, em 2016, o chatbot Tay, desenvolvido para interagir e aprender com jovens entre 18 e 24 anos nas redes sociais. Em poucas horas de Twitter, o software se transformou em um usuário agressivo e preconceituoso. “Colocamos um software avançado, capaz de aprender e tomar decisões de interação, em uma base de dados imensa e sem tratamento”, diz o executivo da Microsoft.

O episódio mudou os rumos do desenvolvimento desse tipo de tecnologia na companhia de Bill Gates. Casos de I.As. intolerantes já foram amplamente registrados. No Facebook, IBM e até no Judiciário dos Estados Unidos. Por isso, David Carmona, gerente-geral de nuvem e inteligência artificial da Microsoft, responsável por levar I.A. dos laboratórios para os produtos da companhia, defende: “Além de acessível, a tecnologia tem de garantir direitos fundamentais, como a privacidade e a segurança das pessoas. Os sistemas também precisam ser justos. A máquina não pode, em hipótese alguma, ferir um humano ou prejudicá-lo em favor de outro”. Transparência é imprescindível. “Só assim conseguiremos enxergar o interior das soluções, identificar os problemas e corrigi-los. Não podemos viver no mundo das caixas-pretas”, completa.

Na seara do aprendizado não supervisionado, no qual as máquinas agrupam os dados sozinhas, há mais risco, como o de interpretação errada das informações, vieses e anomalias. Por outro lado… “Os robôs podem buscar informações ocultas para os humanos, mas que se mostrem estratégicas para o negócio”, explica Fábio Andreotti, do Google. Mais um risco a ponderar na adoção de I.A.

Uma preocupação ronda os especialistas da área. “O aprendizado de máquina depende de um grande volume de dados, nem sempre disponível”, diz Elena Fersman, diretora de pesquisa em I.A. da Ericsson. “Para essas situações, estamos desenvolvendo o raciocínio de máquina.” O método, batizado em inglês de machine reasoning, consiste em combinar diferentes entradas de informação — programação tradicional e aprendizado de máquina — para que o computador consiga deduzir o que fazer, em vez de tentar reconhecer padrões e exceções.

Aprendizado de máquina tem dificuldade para agir diante de cenários novos e para transferir conhecimento de uma tarefa para outra. Elena propõe um exercício de imaginação: o cenário é de caos; um acidente grave numa rede de fornecimento de energia, com componentes avariados, outros desgastados e ameaçando quebrar, oferece risco alto de eletrocutamento na área — e o primeiro técnico a chegar ao local é júnior. “Não dá para contar com reconhecimento de padrões numa situação assim. Seria melhor o técnico ter como auxiliar uma I.A. capaz de raciocinar e deduzir”, afirma. A pesquisadora, Ph.D. em ciência da computação, depositante de mais de 50 grupos de patentes e coordenadora de mais de cem profissionais em cinco países (incluindo o Brasil), acredita que terá protótipos prontos para testes de campo ainda este ano.

Programador é o profissional do futuro, certo? Errado. “A nova fronteira está na criação de modelos automatizados, que vão permitir que mesmo pessoas sem profundo conhecimento técnico de computação treinem as máquinas”, diz David Carmona, da Microsoft. “E acredito na evolução da técnica de ensino de máquina [machine teaching], na qual será possível transcrever para código a experiência dos profissionais humanos e obter sistemas para ensinar as ‘máquinas aprendizes’.”

Com as máquinas programando-se umas às outras, Renato Vicente, Ph.D. na área e cientista-chefe do Experian DataLab, sugere inclusive, a quem deseja trabalhar com as profissões do futuro, estudar filosofia e lógica (leia a entrevista completa com ele). Segundo David, hoje em dia, uma máquina se autotreina buscando dados em ambientes de jogos de tabuleiro, como o xadrez, e simuladores — de voo, guerra e direção, entre outros. “Elas jogam contra elas mesmas, observam plataformas nas quais muita gente joga e vão aprendendo com os dados”, explica o executivo.

Sofia Marshallowitz Apuzzo, cientista de dados do escritório de advocacia Opice Blum, dá um bom exemplo sobre a delicadeza das questões que nos aguardam, como cidadãos e como profissionais. No mundo do Direito, enquanto advogados estão preocupados em perder o emprego, procedimentos arcaicos e pilhas de processos entopem o Judiciário. “Na prática, é possível automatizar tudo, até a sentença de um juiz”, diz a executiva. “Mas temos de pensar: as pessoas querem ser julgadas por um robô?”

Ela acredita que I.A. vai se difundir aos poucos, mas tende a avançar rumo a trabalhos mais sofisticados. “O limite virá da sociedade”, afirma. E de empresários e executivos que saibam ponderar suas decisões sobre como usar a inteligência. Disse Satya Nadella, CEO da Microsoft, em passagem recente pelo Brasil: “É preciso considerar as consequências para a sociedade. Aspectos como privacidade, segurança e confiança são importantes”. Importantes e inegociáveis. (Por Ediane Tiago, com Marcos Coronato, de Barcelona)

POR DENTRO DA CAIXA

Aprendizado de máquina (machine learning)

São modelos estatísticos capazes de aprender com dados. Não precisam seguir instruções explicitamente programadas. Exemplos: análise de crédito, identificação de fraudes, aplicativos de trânsito, recomendações de produtos e vídeos

Processamento de linguagem natural

Habilidade de entender a linguagem humana e extrair informações de textos (leitura), responder (escrita e voz), transformar texto em voz (falar) e seguir instruções faladas (escutar)

Visão computacional

Técnica para ensinar máquinas a “enxergar” e compreender informações contidas em imagens como fotos, vídeos e rostos humanos

Redes neurais

Técnica aplicada no aprendizado de máquina que simula o funcionamento dos neurônios humanos, em que conexões mais úteis se reforçam com o uso. Organiza programas e dados em camadas. Usada em visão computacional e processamento de linguagem natural

Camadas

Estrutura usual para redes neurais. Mais camadas aumentam a capacidade da I.A. de lidar com mais variáveis. “Camadas ocultas” compõem o “cérebro” da máquina, entre a camada de input (que recebe dados e questões) e a camada de output (que oferece respostas)

Aprendizado profundo (deep learning)

É a forma mais complexa de aprendizado de máquina. Aplica-se a áreas como reconhecimento de imagens e de voz. Há I.As. com dezenas e até centenas de camadas

ESPÉCIE EM EVOLUÇÃO

De onde veio e para onde vai a I.A.

Automação de processos

Software que imita ações humanas repetitivas. Lida com mais dados do que um humano conseguiria mas depende de regras claras. Por isso, não configura inteligência artificial

Automação cognitiva

É capaz de entender diferentes formas de expressão humana, como as sentenças em um texto. Quanto mais trabalha, melhor fica seu desempenho

Predição

Aumenta a inteligência humana ao oferecer informações e análises preditivas, baseadas em probabilidades. Possui capacidade básica de aprendizado, o que define inteligência artificial

Engajamento cognitivo

Sistemas simulam o comportamento humano, suas emoções e interações, como o processamento de linguagem natural. Têm capacidade de aprender sozinhos

CHECK LIST

O assédio de fornecedores dificulta a identificação de valor no que é oferecido. Organizações podem definir suas necessidades e questionar potenciais provedores de serviços baseadas num roteiro:

– Qual modelo analítico melhor serve às necessidades?

– Qual método de aprendizagem de máquina a solução usa?

– Que habilidades específicas e nível de experiência são necessários para o uso do serviço?

– Quais dados e em qual volume são necessários para que o serviço funcione?

– Com que frequência a I.A. tem de ser treinada?

Fonte: Guia do CIO para IA, Gartner

Fonte: “Época Negócios”